Lunettes de réalité augmentée : pour quelles nouvelles

interfaces multimédia ?

Une

prochaine génération de technologies de réalité

augmentée émerge avec le développement de lunettes

électroniques. La société Laster technologies développe

un concept original de lunette informative sur verre transparent. Elle

permet d'afficher des informations multimédia directement dans

le champ de vision tout en conservant la vision naturelle (les informations

sont projetées sur un verre transparent semi-réflechissant

alors qu'une micro-caméra embarquée analyse l'environnement

pour contextualiser les informations affichées, l'interactivité

est assurée par une commande vocale ou gestuelle). Cette nouvelle

technologie de vision enrichie interactive (dite de réalité

augmentée "optical

see through") est un nouveau support numérique de diffusion

multimédia. Il ouvre de multiples nouveaux champs d'applications,

mais suppose aussi d'imaginer les nouveaux formats de contenus et services

multimédias associés, et donc de concevoir de nouvelles

formes d'interfaces visuelles et de navigation.

La mobilité, un marché naturel pour la réalité augmentée, en particulier, "optical see through"

Google

via Androïd et son prochain Google Phone se positionne sur le marché

des smartphones, les applications mobiles de réalité augmentée

commencent à fleurir. Apple a déposé des brevets

pour des systèmes permettant de reconnaître et d’établir

un modèle 3D de l’environnement filmé par la caméra

de l’iPhone, pour y associer des couches d’informations multimédia

contextuelles.

L’objectif est d’amener toute la richesse et les applications

qui font le succès du Web, tels que les informations mappées

de « Google Street View », sur le marché de la mobilité

avec les technologies de la réalité augmentée, afin

de contextualiser, personnaliser, associer l’information à

l’environnement immédiat de l’utilisateur.

Cette tendance annonce une prochaine génération de médias,

qu’on pourrait appeler des « t-Medias », car ils sont

associés à des technologies de tracking pour analyser l’environnement

(qu’elles soient à base de reconnaissance vidéo, de

géolocalisation, ou encore, les deux).

Le problème des applications sur smartphone c’est qu’elles

obligent à sans cesse orienter le téléphone pour

capter avec la caméra le décor qu’on souhaite enrichir

et, en particulier dans ces conditions, l’écran est de trop

petite taille, l’enrichissement perd de son impact.

Le prolongement logique est donc d’associer ces nouvelles technologies

et applications à des lunettes électroniques de réalité

augmentée, qui permettent de conserver le champ de vision naturel

tout en offrant un champ d’affichage virtuel beaucoup plus vaste.

En outre, en libérant les mains, le système offre une meilleure

ergonomie et l’utilisateur peut par exemple se servir de sa main

pour naviguer dans les contenus virtuels affichés (via de la reconnaissance

gestuelle).

Un nouveau média qui implique de multiples innovations…

Le développement

de ce nouveau média suppose des innovations à la fois sur

le plan matériel, électronique et optique, sur celui des

technologies et solutions logicielles de tracking, mais aussi sur celui

de l’ergonomie, de la conception de l’interface et des nouveaux

formats d’applications.

Laster technologies travaille dans cette direction dans le cadre de différents

projets, tel que le projet "REVES" (concernant l’expérimentation

d’un dispositif d’exposition à la Cité des Sciences

et de l’Industrie). Laster s’associe avec des laboratoires

reconnus tels que ceux de l’INRIA ou du CNRS, afin d’intégrer

dans ses solutions les dernières technologies d’analyse de

l’image, de tracking, ou encore, d’optimisation pour le rendu

et le tracking temps réel, en particulier sur des systèmes

portables.

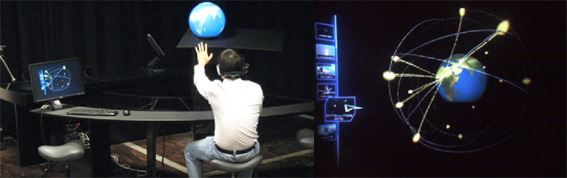

Expérimenté à l’occasion de l’ouverture de la nouvelle exposition permanente de la Cité des sciences « Objectifs Terre : la révolution des satellites », le projet REVES (REality and Virtual Environment Symbiose) est un dispositif d'exposition conçu autour d’un vidéoglobe (écran sphérique qui projette l’image de la Terre en mouvement) placé au centre d’une table interactive.

Les

visiteurs, équipés des lunettes, voient en animations 3D

les satellites en évolution autour du vidéoglobe. Les images

virtuelles sont calées sur les éléments du décor

et recalculées en temps réel. On peut les voir sous différents

angles, afficher aussi des modèles 3D tel qu’un satellite

sur la table (équipée de capteurs) et l’observer comme

un objet réel pour en découvrir toutes les parties. La

navigation dans le menu interactif est effectuée par les gestes

de la main dont la position est repérée par le système.

Ce projet à

été développé dans le cadre d’un consortium

R&D soutenu par l’Agence Nationale de la Recherche composé

de la Cité des sciences et de l’industrie, l’INRIA,

l’Université de Paris 5, la société DreamInReal

et de Laster Technologies.

Dispositif d’exposition en réalité aumentée « REVES » à la Cité des Sciences

Une

nouvelle conception de l’interface visuelle

Avec cette technologie de

vision enrichie interactive, il n’y a plus de support physique visible

(l‘écran est la lunette), l’image est directement affichée

dans le champ de vision. Il y a plus aussi de périphérique

de navigation puisque l’interactivité est gestuelle. Mais

surtout, les contenus multimédias virtuels doivent s’intégrer

dans champ de vision réel, par rapport aux éléments

du décor de l’environnement, enrichir notre vision sans la

gêner, lui apporter du sens plutôt que de la perturber. Et

ce, en situation de mobilité, en fonction de nos mouvements, avec

la nécessité de réactualiser instantanément

les contenus multimédia virtuel en fonction de l’évolution

de notre position, de notre champ de vision et dans les 3 dimensions de

notre déplacement.

Cela suppose donc de repenser la conception de l’interface, de l’interactivité,

les formats de contenus associés. Ce travail dépend aussi

de l’usage et de l’application finale qui sont envisagés.

Une application de géolocalisation pour une aide aux déplacements,

n’aura pas la même configuration qu’un jeu interactif,

qu’une application de bureautique virtuelle, ou encore, qu’un

système d’aide aux mal voyants qui devra accentuer ou interpréter

l’environnement.

Un système de vision enrichie mais pour enrichir quoi et comment,

quelle nouvelle vision ?

En fonction des applications les objectifs seront différents :

enrichir la vue d’un monument ou une publicité magazine en

superposant des informations complémentaires, permettre de voir

les organes au travers du corps d’un patient pour une opération

chirurgicale, de voir l’invisible, dans le passé un bâtiment

disparu ou dans le futur le projet de complexe hôtelier sur un terrain

vague, ou encore, pourquoi pas, d’offrir une vision prédictive

en analysant les mouvements de la circulation pour prédire un accident

si on ne change pas de cap, grossir, déformer, isoler, interpréter

certains éléments du décor pour les mal voyants,

ou tout simplement, afficher des outils bureautique sans gêner le

champ de vision.

Comment fusionner les éléments virtuels dans la vision réelle

pour qu’ils apportent du sens, de l’interprétation,

de l’intelligence à la vision. Il faut analyser un ensemble

d’aspects tels que l’ergonomie du système, les usages

et objectifs du programme interactif, ou encore, les mécanismes

physiologiques et psychoperceptifs de la vision pour optimiser cette nouvelle

vision.

Qu’elle est le contexte d’utilisation de l’application,

en situation de mobilité ou pas, dans quel environnement, pour

quels objectifs ? Dans un programme pour la visite d’un site touristique

les contenus virtuels devront s’intégrer et se caler sur

les éléments patrimoniaux du décor qu’on veut

valoriser. Dans un programme de jeu, par exemple, on pourra jouer sur

des effets de « hors champ » avec des animations et personnages

virtuels cachés en arrière plan derrière des éléments

du décor réel. Dans un programme de géolocalisation

(visière d’un casque moto), les éléments directionnels

d’aide au déplacement devront s’afficher dans le champ

de vision sans le masquer pour ne pas perturber la conduite. Contrairement

à ce qu’on pourrait penser, on aura peut-être intérêt

dans ce dernier cas à les placer dans le champ de vision centrale,

pour ne pas inviter à détourner le regard de la route, et

à jouer sur des effets de transparence des éléments

virtuels intégrés pour continuer à voir l’intégralité

du paysage.

Les aspects liés à la nature du support (verre semi réfléchissant

où le virtuel se superpose au réel) sont aussi à

prendre en compte dans la conception visuelle de l’interface. Il

y a par exemple des couleurs et des textures qui passent mieux. Il faudra

aussi tenir compte des variations de l’environnement réel

dans le rendu des éléments virtuels intégrés

dans le champ, de la complexité du décor réel, luminosité,

ou encore, profondeur de champ. Ainsi, par exemple, varier la luminosité

des éléments virtuels lors du passage dans une zone d’ombre,

déterminer si l’objet virtuel doit être masqué

ou pas, en s’affichant devant un élément du décor

réel (typiquement la main doit passer en premier plan pour la navigation

dans les contenus interactifs). Tout cela, suppose donc le développement

de systèmes d’analyse de reconnaissance de l’image

capable de reconnaître les formes et de reconstruire le modèle

3D de l’environnement qui est dans le champ de vision.

De

nouveaux modes d’interaction et interfaces de navigation

Plus de souris, la navigation

est gestuelle (ou vocale), cela suppose donc le développement de

nouveaux modes de navigation interactive et de repenser aussi l’interface

de navigation.

Le référent culturel en la matière est celui du bureau

de l’ordinateur et de la navigation via la souris dans des menus

ou des icônes. Sur les écrans « multitouch »

(type iPhone, par exemple) nous naviguons déjà sans périphériques

avec des gestes plus intuitifs car inspirés de notre gestuelle

naturelle, l’action par exemple qui consiste à écarter

ou rapprocher les doigts pour agrandir ou diminuer une image, de les pivoter

pour la faire tourner, de poser le doigt et de la faire glisser pour la

poser ailleurs. Comme un objet physique qu’on pourrait manipuler.

Avec la réalité augmentée « optical see through

» un nouveau pas est franchi vers cette conception intuitive de

la navigation. L’objectif est d’aller vers des modes de navigation

encore plus intuitifs qui associent des réflexes issus de notre

gestuelle naturelle à notre culture de l’interface PC. Il

faut que l’apprentissage du système soit naturel et réduit

à son strict minimum.

Sur la première version du programme interactif du projet REVES,

l’interface est classique, inspirée des applications multimédia

standards. On déplace un curseur avec la main vers des menus interactifs

pour naviguer dans les différentes animations.

Avec le développement des algorithmes de reconnaissance gestuelle,

une grammaire gestuelle plus élaborée a été

définie pour les versions suivantes. Celle-ci décompose

un ensemble de gestes correspondants à des fonctions élémentaires

qui associés permettront de naviguer dans les contenus (désigner/activer,

prendre/déplacer/relâcher, ouvrir/fermer,…). Elle s’inspire

d’une gestuelle naturelle comme fermer la main pour « prendre

», la bouger pour «déplacer ». etc…

Les tests effectués auprès du public de la Cité des

Sciences ont confirmé cette approche. Dès lors que les images

virtuelles s’affichent dans le champ de vision et se confondent

avec l’environnement réel le réflexe naturel est d’essayer

de les attraper, les déplacer par exemple comme un objet réel.

Lors des tests des réflexes d’interaction ont été

noté des utilisateurs, issus de notre culture multimédia,

comme celui d’essayer d’appuyer avec le doigt sur des zones

sensibles de l’image (comme les menus) pour activer une interaction

dans sur un écran tactile. Ces travaux ont été intégrés

pour construire une prochaine interface de navigation qui permettra de

naviguer avec une gestuelle intuitive, d’abord en désignant

et manipulant les objets virtuels qui sont dans la scène (premier

niveau de navigation),ensuite avec des outils et des menus contextuels

qui pourront être affiché/desaffiché pour des fonctions

plus avancées.

La navigation est conçue, en outre, de manière dynamique,

c’est-à-dire, qu’elle doit évoluer en fonction

des mouvements, des changements de scène vue, de l’enrichissement

virtuel affiché et dans les 3 dimensions du déplacement.

Laster technologies a mis en place de multiples partenariats et une équipe

multi-disciplinaires. Cette organisation permet de fusionner les compétences

utiles pour associer aux développements technologiques matériels

et logiciels, les innovations nécessaires en termes d’application

finale. Tous ces champs d’innovations sont liés, et en dernier

lieu, ce sont les aspects liés à l’ergonomie, à

la bonne intégration des interfaces virtuelles dans le champ de

vision, l’adaptation aux besoins, la plus value des applications,

qui feront le succès de ce nouveau média.

Michel Agnola